Một nhóm các nhà nghiên cứu tại Đại học Tokyo đã xây dựng cầu nối giữa các mô hình ngôn ngữ lớn (LLM) và robot mà hứa hẹn có nhiều cử chỉ giống con người hơn trong khi loại bỏ các điều khiển phụ thuộc vào phần cứng truyền thống.

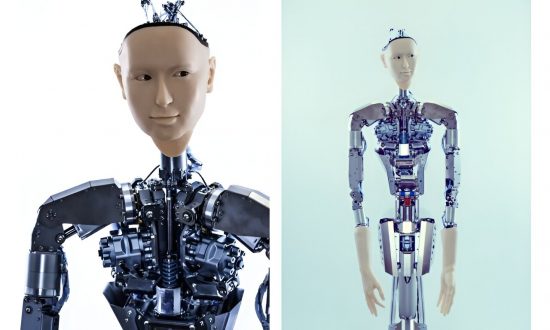

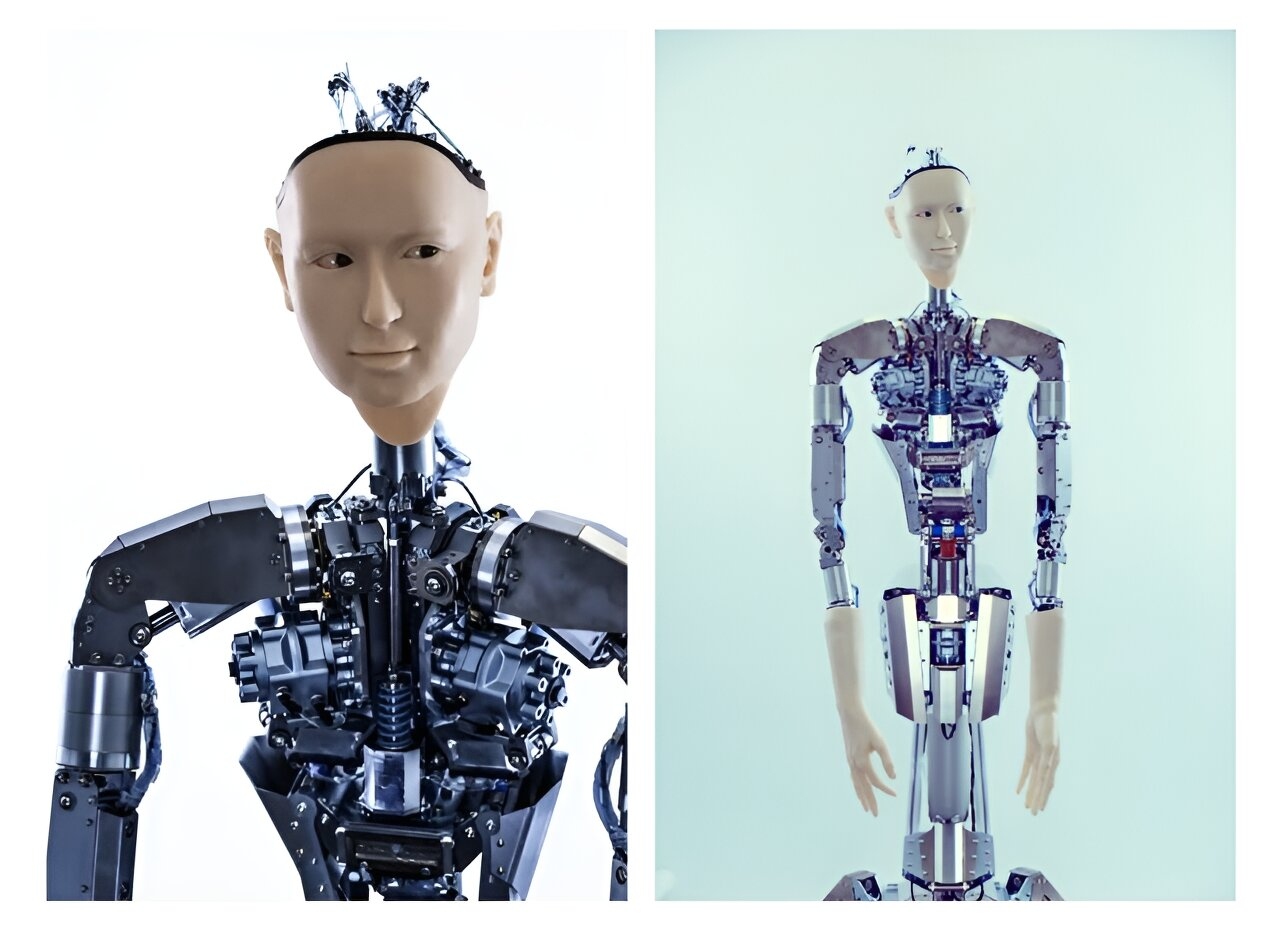

Alter3 là phiên bản mới nhất của robot hình người được triển khai lần đầu tiên vào năm 2016. Các nhà nghiên cứu hiện đang sử dụng GPT-4 để hướng dẫn robot thực hiện nhiều mô phỏng khác nhau, chẳng hạn như chụp ảnh tự sướng, ném bóng, ăn bỏng ngô và chơi guitar.

Trước đây, những hành động như vậy sẽ yêu cầu mã hóa cụ thể cho từng hoạt động, nhưng việc kết hợp GPT-4 sẽ mang đến nhiều khả năng mới cho robot học từ hướng dẫn bằng ngôn ngữ tự nhiên.

Các nhà nghiên cứu cho biết trong một nghiên cứu gần đây, các robot được hỗ trợ bởi AI “chủ yếu tập trung vào việc tạo điều kiện giao tiếp cơ bản giữa con người và robot trong máy tính, sử dụng LLM để diễn giải và làm giả theo các phản ứng giống như người thực”.

Họ cho biết: “Điều khiển trực tiếp hiện đã khả thi bằng cách ánh xạ các biểu hiện ngôn ngữ của hành động con người lên cơ thể robot thông qua mã chương trình”. Họ gọi tiến bộ này là “một sự chuyển đổi mô hình”.

Alter3, có khả năng chuyển động phức tạp ở phần trên cơ thể, bao gồm cả biểu cảm khuôn mặt chi tiết, có 43 trục mô phỏng chuyển động cơ xương của con người. Nó nằm trên một bệ nhưng không thể đi lại (mặc dù nó có thể bắt chước việc đi bộ).

Việc mã hóa sự phối hợp của rất nhiều khớp là một nhiệm vụ lớn liên quan đến các chuyển động lặp đi lặp lại nhiều lần.

Các tác giả cho biết: “Nhờ có LLM, chúng tôi hiện đã không còn phải làm việc lặp đi lặp lại nữa”.

Giờ đây, họ có thể chỉ cần cung cấp hướng dẫn bằng lời nói mô tả các chuyển động mong muốn và đưa ra lời nhắc hướng dẫn LLM tạo mã Python chạy công cụ Android.

Alter3 lưu giữ các hoạt động trong bộ nhớ và các nhà nghiên cứu có thể tinh chỉnh và điều chỉnh hành động của nó, dẫn đến chuyển động nhanh hơn, mượt mà hơn và chính xác hơn theo thời gian.

Các nhà nghiên cứu cho biết, việc sử dụng LLM trong nghiên cứu chế tạo robot “xác định lại ranh giới của sự hợp tác giữa con người và robot, mở đường cho các thực thể robot thông minh hơn, linh hoạt và thân thiện hơn”.

Họ còn đưa thêm một chút hài hước vào hoạt động của Alter3. Trong một tình huống, robot giả vờ ăn một túi bỏng ngô chỉ để biết rằng nó thuộc về người ngồi bên cạnh. Biểu cảm khuôn mặt và cử chỉ cánh tay cường điệu thể hiện sự ngạc nhiên và bối rối.

Alter3 được trang bị camera có thể "nhìn thấy" con người. Các nhà nghiên cứu phát hiện ra rằng Alter3 có thể tinh chỉnh hành vi của nó bằng cách quan sát phản ứng của con người. Họ so sánh việc học như vậy với sự bắt chước của trẻ sơ sinh, điều mà các nhà nghiên cứu hành vi quan sát thấy ở trẻ sơ sinh.

Các nhà nghiên cứu cho biết, khả năng học tập "zero-shot", của các robot được kết nối GPT-4 "có khả năng xác định lại ranh giới của sự hợp tác giữa con người và robot, mở đường cho các thực thể robot thông minh hơn, linh hoạt và thân thiện hơn".

Nghiên cứu hiện đã được đăng trên máy chủ in trước arXiv.

Theo Phys.org