Trong bài trước, chúng tôi đã giới thiệu: Những hạn chế nổi bật của các mô hình trí tuệ nhân tạo, bài này sẽ giới thiệu một số ví dụ vui về các kết quả dự đoán của các mô hình AI hiện tại. Thông qua những ví dụ này, chúng ta có thể sẽ hiểu được những hạn chế của các mô hình trí tuệ nhân tạo rõ hơn.

Bởi vì chúng ta vẫn chưa giải thích được các kết quả dự đoán từ các mô hình trí tuệ nhân tạo, và chúng ta cũng chưa kiểm soát được các mô hình trí tuệ nhân tạo, cho nên các kết quả dự đoán từ các mô hình trí tuệ nhân tạo thường khá bất ngờ và thú vị. Đa số là các kết quả dự đoán sẽ bị sai khi chúng ta chỉnh một số thông tin nhỏ ở đầu vào (input) của mô hình.

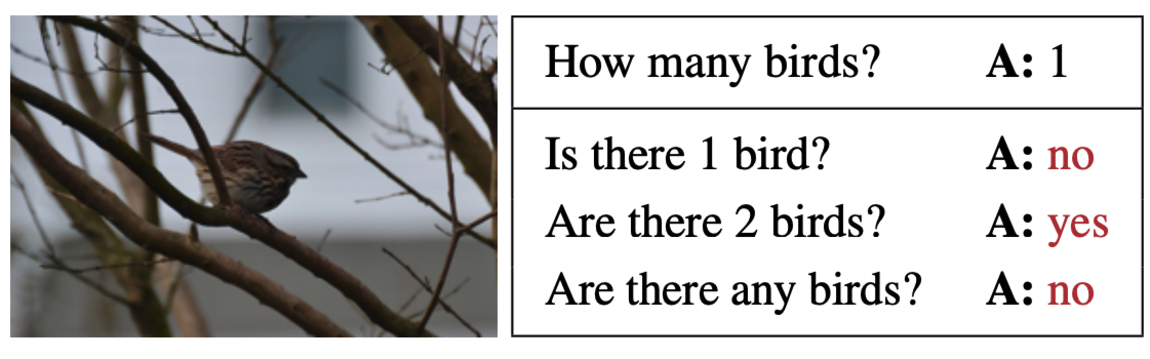

1. Hạn chế của các mô hình trí tuệ nhân tạo trong bài toán Visual Question Answering

Ví dụ như hình ảnh bên dưới, mô hình trí tuệ nhân tạo được đào tạo để có khả năng trả lời các câu hỏi liên quan đến hình ảnh. Đầu vào (input) là một hình ảnh và các câu hỏi tương ứng; đầu ra (output) là các câu trả lời cho các câu hỏi. Bài toán này được gọi là Visual Question Answering (VQA), có thể dịch sang tiếng Việt là hỏi và trả lời liên quan đến hình ảnh.

-

- Ảnh chụp màn hình từ paper với tiêu đề: “Are Red Roses Red? Evaluating Consistency of Question-Answering Models” được đăng tại hội nghị ACL 2019.

Khi chúng ta hỏi câu hỏi “How many birds?" (tạm dịch: có bao nhiêu con chim?), thì mô hình AI có thể trả lời chính xác là có 1 con chim trong hình ảnh. Lúc này, mô hình AI có thể trả lời chính xác là vì mô hình AI được học (huấn luyện) từ rất nhiều dữ liệu mà có những mẫu câu hỏi tương tự.

Nếu chúng ta thay đổi cách hỏi một chút, giả sử chúng ta sử dụng cách hỏi yes hoặc no (đúng hoặc không), chúng ta hỏi “Is there 1 bird?” (tạm dịch: có phải có 1 con chim không?), rõ ràng lúc này câu trả lời đúng phải là yes (đúng vậy). Tuy nhiên mô hình AI lại dự đoán câu trả lời là no (không phải là có một con chim). Từ ví dụ này, chúng ta có thể thấy rằng, mô hình AI chưa hoàn toàn thông minh và chính xác như mọi người vẫn nghĩ.

Tương tự cho hai câu hỏi tiếp theo “Are there 2 birds?” (tạm dịch: có hai con chim phải không?) và “Are there any birds" (tạm dịch: có con chim nào không?) thì các kết quả dự đoán từ mô hình AI đều chưa chính xác.

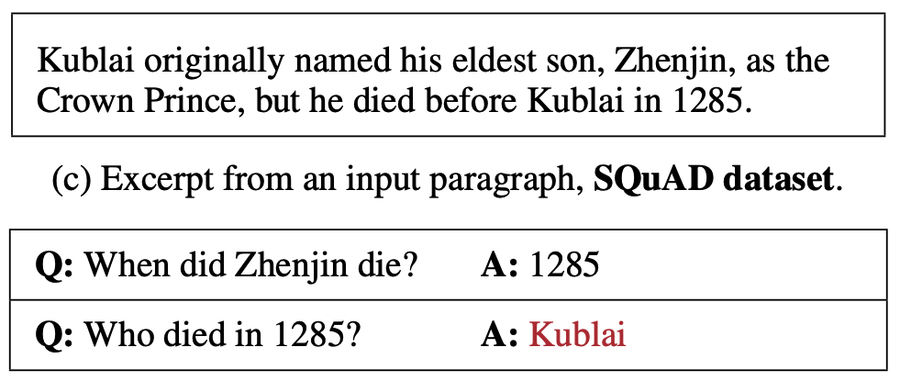

2. Bài toán Machine Reading Comprehension

Một ví dụ khác là về bài toán đọc hiểu văn bản (machine reading comprehension). Đầu vào là một đoạn văn và một hoặc nhiều câu hỏi liên quan đến đoạn văn; đầu ra là các câu trả lời cho các câu hỏi.

Hình bên dưới mô tả một ví dụ được lấy từ bộ dữ liệu SQuAD. SQuAD là từ viết tắt của cụm từ “Stanford Question Answering Dataset”; SQuAD là một tập dữ liệu được tạo ra dùng để huấn luyện và đánh giá các mô hình trong bài toán đọc hiểu văn bản.

-

- Ảnh chụp màn hình từ paper với tiêu đề: “Are Red Roses Red? Evaluating Consistency of Question-Answering Models” được đăng tại hội nghị ACL 2019.

Trong ví dụ trên, câu “Kublai originally named his eldest son, Zhenjin, as the Crown Prince, but he died before Kublai in 1285.” là một câu trong đoạn văn đầu vào. Tạm dịch là: “Kublai ban đầu đặt tên cho con trai cả của mình là Zhenjin, là Thái tử, nhưng Zhenjin đã qua đời vào năm 1285 trước Kublai”.

Với câu hỏi đầu tiên: “When did Zhenjin die?” (tạm dịch là Zhenjin đã qua đời khi nào?), mô hình AI đã có thể đưa ra câu trả lời chính xác là vào năm 1285. Trong trường hợp này, mô hình AI có thể đưa ra câu trả lời chính xác là vì mô hình AI đã học được rất nhiều những mẫu ví dụ dạng như này.

Tuy nhiên, khi chúng ta đổi cách hỏi khác đi 1 chút, ví dụ chúng ta hỏi: “Who died in 1285?” (tạm dịch là ai đã qua đời vào năm 1285), thì lúc này mô hình AI đã không còn khả năng đưa ra câu trả lời chính xác. Điều này cho thấy, các mô hình trí tuệ nhân tạo không hoàn toàn thật sự hiểu được đoạn văn và câu hỏi.

Xem thêm:

- Trí tuệ nhân tạo là gì? Top 10 ứng dụng của AI trong cuộc sống

- Những kiến thức cơ bản về AI dành cho mọi người

- Có thể học trí tuệ nhân tạo ở đâu? Và học như thế nào?

- Điểm chuẩn ngành trí tuệ nhân tạo 2022

- Điểm chuẩn ngành công nghệ thông tin 2021

- ChatGPT là gì?

Nguồn tham khảo:

Nghiên cứu khoa học của nhóm tác giả bao gồm: Marco Tulio Ribeiro (từ Microsoft Research), Carlos Guestrin (University of Washington), Sameer Singh (University of California, Irvine). Are Red Roses Red? Evaluating Consistency of Question-Answering Models, ACL 2019.